Фабрика искусственного интеллекта – предпосылки, практика, перспектива

В целях масштабирования и совершенствования аналитических решений ведущие игроки используют концепцию MLOps:

Классические BI инструменты для более точного управления бизнес-процессами, например, создание виртуального прототипа реального объекта.

Повышение эффекта от классических BI инструментов - становится все более значимым потенциал монетизации данных с использованием технологии BigData, продвинутой аналитики, машинного обучения.

Лавинообразный рост количества задач бизнеса к использованию решений с ИИ.

Ключевые преимущества MLOps:

- Сокращение TTM (time-to-market)

- Масштабирумость

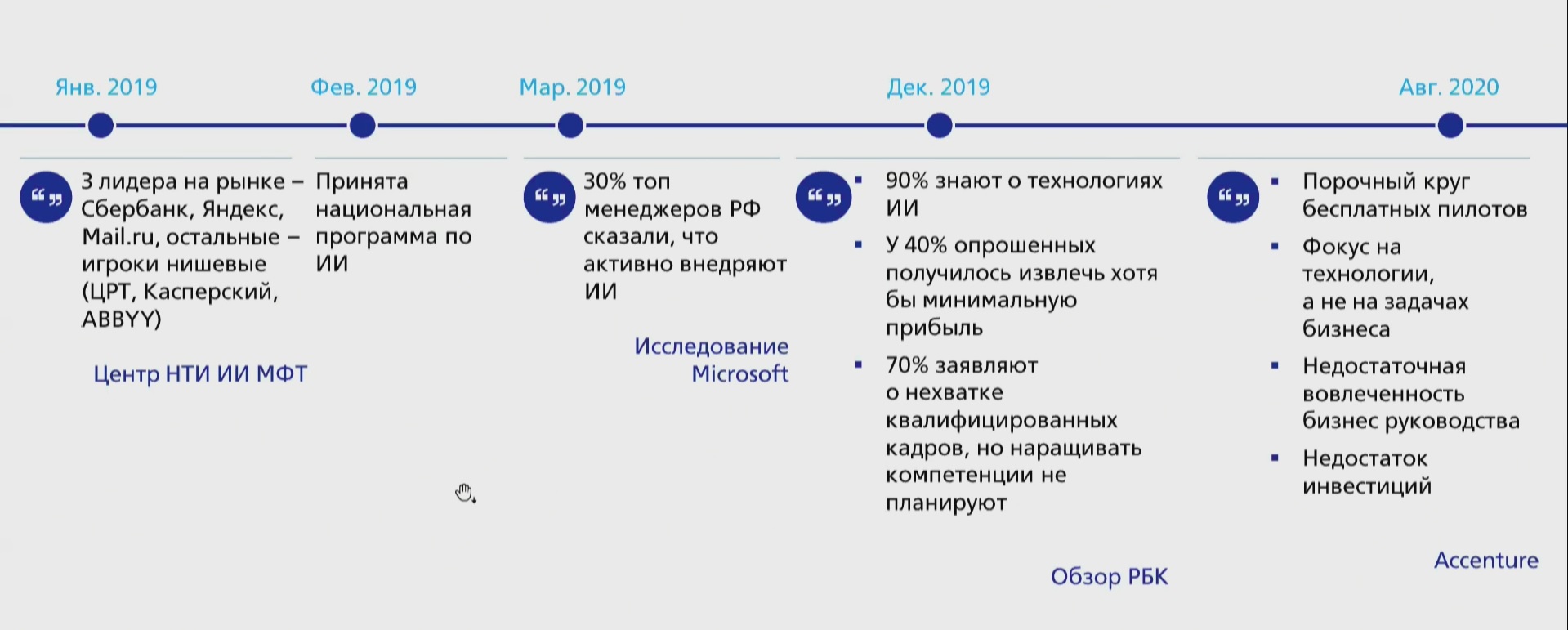

Ниже рассмотрим "Запрос бизнеса к ИИ в Российской Федерации"

Жизненный цикл модели:

Как мы могли заметить раньше преобладал Классический путь внедрения модели:

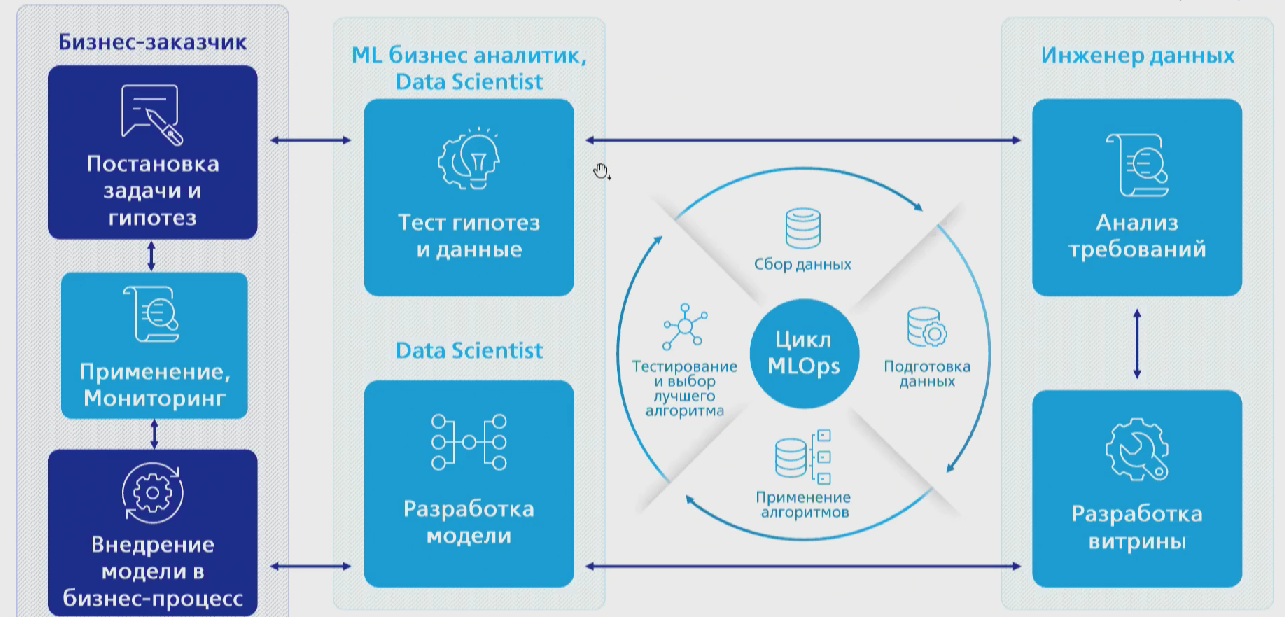

Рассмотрим роли в рамках процесса создания Модели:

Бизнес/Функция

1. Бизнес-заказчик - формирует требования для разрабатываемого решения, ответственен за интеграцию и реализацию бизнес-эффекта.

2. Предметные эксперты формируют бизнес-гипотезы и проверяют результаты аналитики со стороны бизнес-опыта.

3. Конечные пользователи предоставляют вводные по бизнес-процессу.

Подразделение аналитики

1. Бизнес-Партнер - проводит синтез выводов, ответственен за постановку задач для Data Scientist и Инженеров Данных на основании требований бизнес-заказчика.

2. Data Scientist - разрабатывает статические модели и алгоритмы.

3. Data Engineer - адаптирует и интегрирует модели для применения.

Так же, можно отметить несколько способов сокращения среднего времени разработки и внедрения решений:

Конвейер MLOps с автоматизацией

Надлежащий процесс разработки моделей машинного обучения, соответствующий agile-принципам и существующим ролям

Обучение Data scientit-ов эффективным методам разработки ПО

Вывод:

Рассмотрим фирму "Tele2" в качестве примера:

Обзор:

Чем больше времени проходит с момента появления данных, тем потенциальная выгода от их использования сильно уменьшается. Каппа-архитектура и потоковая обработка данных появилась в связи с необходимостью гарантировать минимальную задержку.

Пример:

Вы пришли в магазин и оформляете кредит на покупку телефона. Вы хотите получить его на выгодных условиях. И банк хочет дать кредит проверенному клиенту. Временное окно, в течение которого вам нужны кредитные деньги, относительно короткое.

Преимущества системы "Tele2":

"Для поддержки потоковых приложений мы хотели сохранить тот же способ автоматизации, единую точку контроля, что и для пакетных приложений, а также минимизировать количество используемых ресурсов."

Концепт:

Доработка генерации DAG

Достаточно добавить поддержку генерации SSH-оператора для нашей системы автоматизации, которая позволит проверить состояние задания.

Конфигурация YAML

Доработка позволяет определить команду для удаленного выполнения и дополнительные контейнеры для Pod`a, которые могут подключать дополнительную логику.

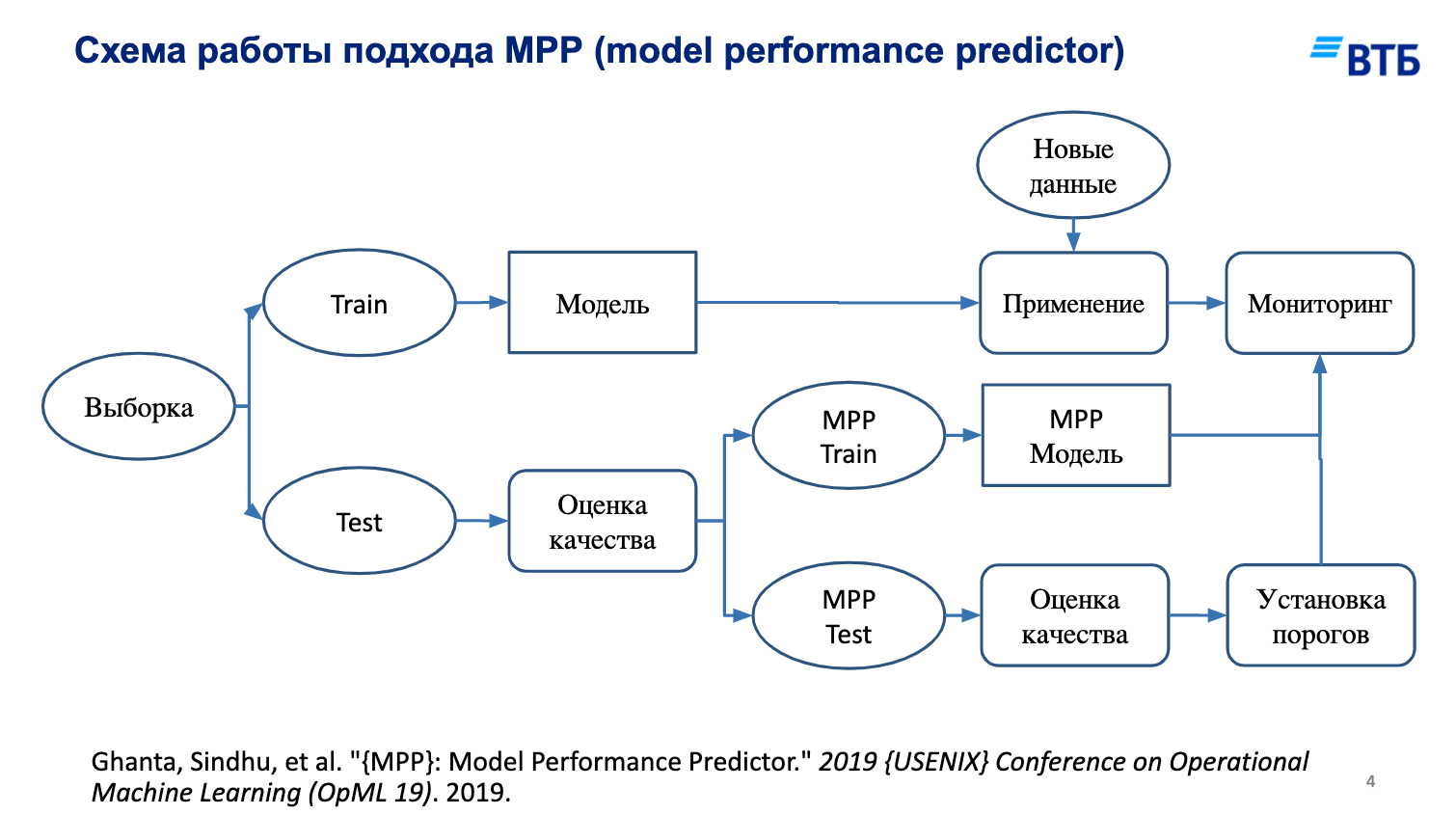

А так же рассмотрим MPP подход в AutoML задачах

Эволюция построения моделей. Запрос на AutoML.

В настоящее время трудно получить конкурентное преимущество на рынке за счёт улучшения только моделей. Большинство SOTA-алгоритмов доступно в виде open-source библиотек. В то же время существует множество других областей для получения преимущества.

Обширный периметр разнообразных данных.

AutoML для быстрого построения моделей.

Точность и актуальность прогнозов.

Стабильность прогнозов в каждый момент времени.

Что такое AutoML?

Автоматическое машинное обучение (AutoML) - это процесс автоматизации сквозного процесса применения машинного обучения к задачам реального мира.

Даёт преимущество получения более простых решений, более быстрого создания таких решений и моделей, которые не уступают простроенных вручную.

Мотивация использования MPP подхода:

Model Performance Predictor

Model Performance Predicto (MPP) - подход построения вспомогательной, мониторинговой, модели для предсказания качества работы основной.

Целевая переменная MPP - это метрика качества работы основной модели.

Применим к любым задачам и моделям

Не требует дополнительных данных

Контроль модели с точки зрения целевой переменной

Актуальность прогнозов при любом обновлении данных

Результаты применения MPP-подхода в AutoML-задачах

Mpp модель оценивает совместное распределение факторов с точки зрения работы основной модели, реагируя не на величину изменений в распределениях отдельных слоёв данных, а на общий сдвиг качества работы основной модели.